Hôm nay, Google Cloud đã giới thiệu các phiên bản mới hướng đến AI, được hỗ trợ bởi CPU Axion và Ironwood TPU của riêng mình. Các phiên bản mới này hướng đến cả mục đích đào tạo và suy luận độ trễ thấp cho các mô hình AI quy mô lớn. Tính năng chính của các phiên bản mới này là khả năng mở rộng hiệu quả các mô hình AI, được hỗ trợ bởi quy mô mở rộng cực lớn của các hệ thống dựa trên Ironwood của Google.

Hàng triệu Ironwood TPU dùng cho đào tạo và suy luận.

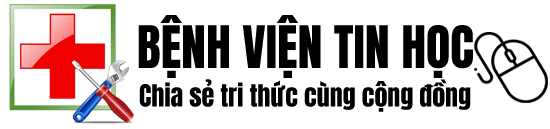

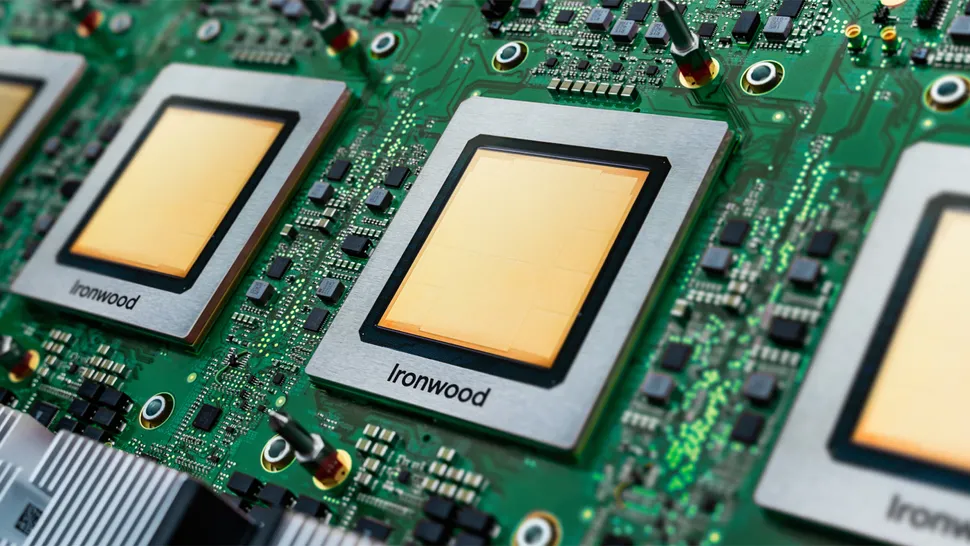

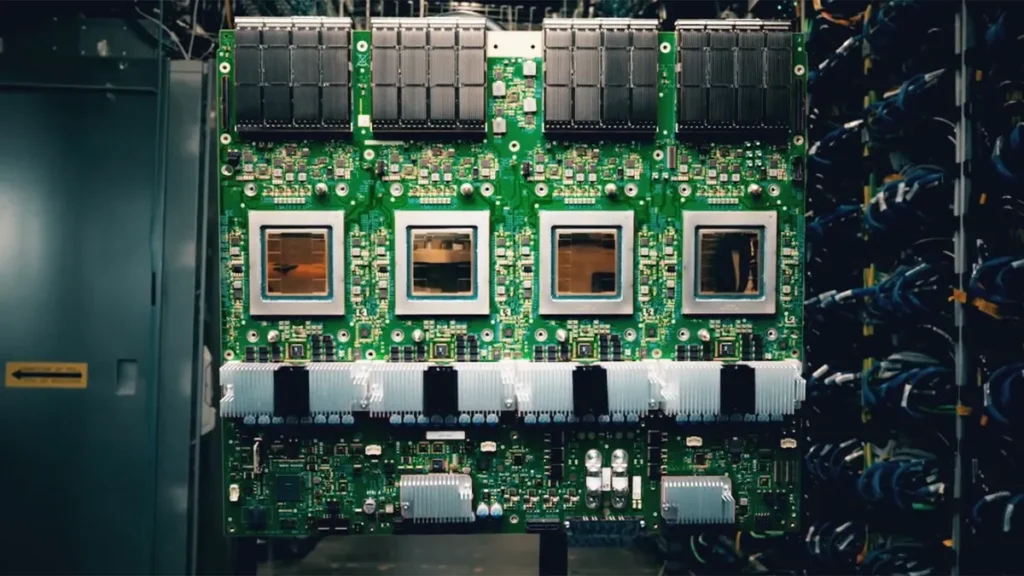

Ironwood là bộ xử lý tensor (TPU) thế hệ thứ 7 của Google, cung cấp hiệu suất 4.614 FP8 TFLOPS và được trang bị bộ nhớ HBM3E 192 GB, cung cấp băng thông lên đến 7,37 TB/giây. Các pod Ironwood có thể mở rộng lên đến 9.216 bộ tăng tốc AI, cung cấp tổng cộng 42,5 FP8 ExaFLOPS cho việc huấn luyện và suy luận, vượt xa khả năng FP8 của hệ thống NVL72 GB300 của Nvidia hiện đang ở mức 0,36 ExaFLOPS. Pod được kết nối với nhau bằng mạng Inter-Chip Interconnect 9,6 Tb/giây độc quyền và mang tổng cộng khoảng 1,77 PB bộ nhớ HBM3E, một lần nữa vượt trội hơn so với khả năng của nền tảng đối thủ của Nvidia.

Các pod Ironwood — dựa trên CPU Axion và Ironwood TPU — có thể được kết nối thành các cụm chạy hàng trăm nghìn TPU, tạo thành một phần của Siêu máy tính AI (AI Hypercomputer) của Google. Đây là một nền tảng siêu máy tính tích hợp, kết hợp tính toán, lưu trữ và mạng dưới một lớp quản lý. Để tăng cường độ tin cậy của cả các pod siêu lớn và Siêu máy tính AI, Google sử dụng nền tảng có thể cấu hình lại, được gọi là Chuyển mạch Mạch Quang (Optical Circuit Switching), giúp định tuyến ngay lập tức bất kỳ sự gián đoạn phần cứng nào để duy trì hoạt động liên tục.

Dữ liệu của IDC ghi nhận mô hình Siêu máy tính AI có ROI trung bình ba năm là 353%, chi phí CNTT thấp hơn 28% và hiệu quả hoạt động cao hơn 55% cho khách hàng doanh nghiệp.

Một số công ty đã áp dụng nền tảng dựa trên Ironwood của Google. Anthropic có kế hoạch sử dụng tới một triệu TPU để vận hành và mở rộng dòng sản phẩm Claude của mình, với lý do chi phí/hiệu suất được cải thiện đáng kể. Lightricks cũng đã bắt đầu triển khai Ironwood để đào tạo và phục vụ hệ thống đa phương thức LTX-2 của mình.

CPU Axion: Google cuối cùng cũng triển khai bộ xử lý tự thiết kế

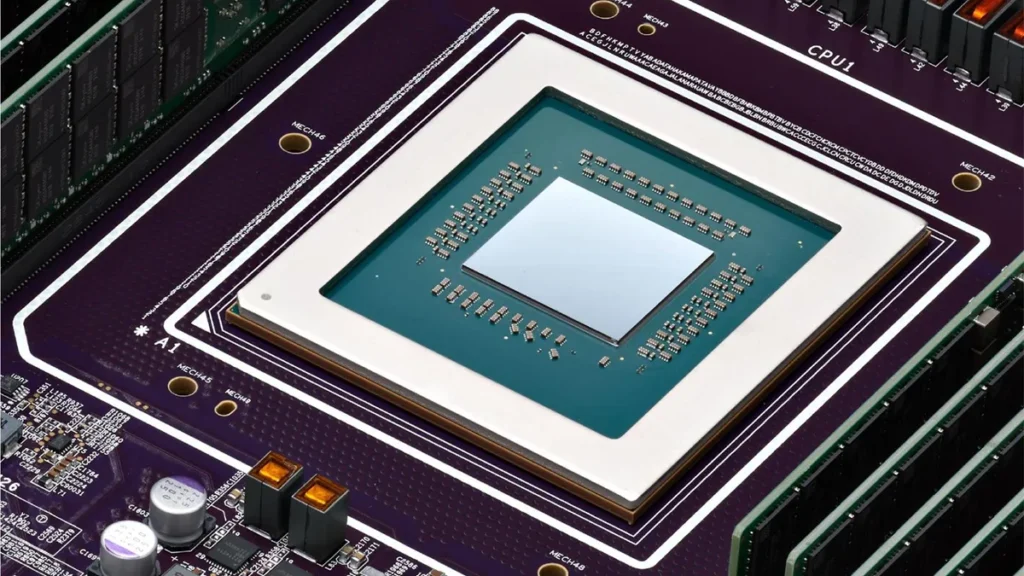

Mặc dù các bộ tăng tốc AI như Ironwood của Google có xu hướng chiếm lĩnh mọi sự chú ý trong kỷ nguyên điện toán AI, CPU vẫn cực kỳ quan trọng đối với logic ứng dụng và lưu trữ dịch vụ cũng như chạy một số khối lượng công việc AI, chẳng hạn như thu thập dữ liệu. Vì vậy, cùng với TPU thế hệ thứ 7, Google cũng đang triển khai bộ xử lý đa năng đầu tiên dựa trên Armv9, có tên là Axion.

Google chưa công bố thông số kỹ thuật đầy đủ cho CPU Axion của mình: không có số lượng lõi được xác nhận trên mỗi die (ngoài tối đa 96 vCPU và tối đa 768 GB bộ nhớ DDR5 cho phiên bản C4A Metal), không có tốc độ xung nhịp được tiết lộ và không có nút quy trình nào được công khai chi tiết cho bộ phận này. Những gì chúng ta biết là Axion được xây dựng xung quanh nền tảng Arm Neoverse v2 và được thiết kế để cung cấp hiệu suất cao hơn tới 50% và hiệu suất năng lượng cao hơn tới 60% so với CPU x86 hiện đại, cũng như hiệu suất cao hơn 30% so với ‘các phiên bản dựa trên Arm đa năng nhanh nhất hiện có trên đám mây ngày nay. Có báo cáo rằng CPU cung cấp 2 MB bộ nhớ đệm L2 riêng cho mỗi lõi, 80 MB bộ nhớ đệm L3, hỗ trợ bộ nhớ DDR5-5600 MT/s và Truy cập bộ nhớ thống nhất (UMA) cho các nút.

Các máy chủ chạy CPU Axion và CPU Ironwood của Google được trang bị bộ điều khiển Titanium tùy chỉnh của công ty, giúp giảm tải việc xử lý mạng, bảo mật và lưu trữ I/O khỏi CPU chủ, cho phép quản lý tốt hơn, mang lại hiệu suất cao hơn.

Nhìn chung, CPU Axion có thể phục vụ cả máy chủ AI và máy chủ đa năng cho nhiều tác vụ khác nhau. Hiện tại, Google cung cấp ba cấu hình Axion: C4A, N4A và C4A metal.

C4A là sản phẩm đầu tiên và chủ chốt trong dòng máy chủ chạy Axion của Google, đồng thời cũng là sản phẩm duy nhất hiện có trên thị trường. Máy chủ này cung cấp tối đa 72 vCPU, 576 GB bộ nhớ DDR5 và mạng 100 Gbps, kết hợp với ổ SSD Titanium dung lượng cục bộ lên đến 6 TB. Máy chủ này được tối ưu hóa để duy trì hiệu suất cao trên nhiều ứng dụng khác nhau.

Tiếp theo là phiên bản N4A, cũng nhắm đến các khối lượng công việc chung như xử lý dữ liệu, dịch vụ web và môi trường phát triển, nhưng có khả năng mở rộng lên đến 64 vCPU, 512 GB RAM DDR5 và mạng 50 Gbps, khiến nó trở thành một sản phẩm có giá cả phải chăng hơn.

Mô hình xem trước khác là C4A Metal, một cấu hình bare-metal được cho là sẽ cung cấp toàn bộ phần cứng Axion trực tiếp cho khách hàng: tối đa 96 vCPU, 768 GB bộ nhớ DDR5 và mạng 100 Gbps. Phiên bản này được thiết kế cho các ứng dụng chuyên biệt hoặc bị hạn chế giấy phép hoặc phát triển dựa trên ARM.

Danh mục silicon tùy chỉnh hoàn chỉnh

Những sản phẩm mới này được xây dựng dựa trên một thập kỷ phát triển silicon tùy chỉnh của Google, bắt đầu với TPU ban đầu và tiếp tục thông qua VCU của YouTube, bộ xử lý di động Tensor và cơ sở hạ tầng Titanium. CPU Axion — bộ xử lý máy chủ đa năng dựa trên Arm đầu tiên của Google — hoàn thiện danh mục chip tùy chỉnh của công ty và Ironwood TPU tạo tiền đề cho sự cạnh tranh với các bộ tăng tốc AI tốt nhất trên thị trường.